Home » Blog » Web Marketing » Google BERT update: tutto quello che c’è da sapere

Google BERT update: tutto quello che c’è da sapere

Google BERT è l’algoritmo di Google entrato in funzione il 25 Ottobre del 2019. A detta di Google trattasi di uno dei maggiori update degli ultimi 5 anni.

Con questo articolo vediamo di capirne di più su questo nuovo algoritmo. In particolare vedremo come funziona Google BERT e il suo impatto sulla SEO.

Cos’è Google BERT

BERT, acronimo di Bidirectional Encoder Representations from Transformers, è un algoritmo di Google che aiuta il motore di ricerca a comprendere meglio il significato delle parole in una frase, in particolar modo nelle ricerche vocali.

Il suo funzionamento influisce su circa il 10% delle query mondiali, con un impatto diretto sul posizionamento. È tutt’altro che un piccolo update.

Da precisare che Google BERT non è solo un algoritmo di Google ma anche un progetto di ricerca open source con tanto di pubblicazione accademica. In particolare trattasi di un framework NLP per l’elaborazione del linguaggio naturale.

Quali problemi risolve Google BERT

Vi sono cose che noi esseri umani comprendiamo e i computer no. Basti pensare ad esempio all’ironia, ai modi di dire ecc.. Naturalmente anche i motori di ricerca da questo punto di vista sono stupidi.

Per un motore di ricerca la comprensione delle parole rappresenta un gran problema poiché da una interpretazione errata deriva una SERP irrilevante e di conseguenza un disservizio.

Il problema è che molte parole sono problematiche in quanto alcune sono ambigue, polisemiche o sinonimi di altre parole.

Questo problema si intensifica con le ricerche vocali, dove a volte la pronuncia, a causa di cadenze, dialetti e accenti, porta a formulare frasi molto simili ad altre.

Per fare un esempio, in inglese la pronuncia delle frasi “four candles” e “fork handles” differisce solo dall’accento, ma il significato è completamente diverso. Così come “beach” e “bitch”.

Oltretutto vi sono parole che assumono un significato completamente diverso a seconda del contesto in cui si utilizzano. Insomma un bel grattacapo per i nostri amici elettronici.

Noi umani siamo in grado di comprendere il contesto di una frase e quindi di dare il giusto significato anche quando una parola di per sé viene interpretata male nel momento in cui la ascoltiamo. Ma i computer no.

BERT è stato progettato per aiutare a comprendere frasi ambigue composte da molte parole con significati multipli.

Come funziona Google BERT

Questo algoritmo ha notevolmente accelerato la comprensione del linguaggio umano, entusiasmando le comunità ML e NPL di machine learning poiché questa ricerca ha richiesto un’enorme mole di lavoro.

Prima di essere definitivamente implementato tra gli algoritmi di Google, BERT è stato testato sull’intero database di Wikipedia che solo in inglese conta più di 2.500 milioni di parole.

Ma scendiamo un po’ più nei dettagli sul funzionamento di BERT.

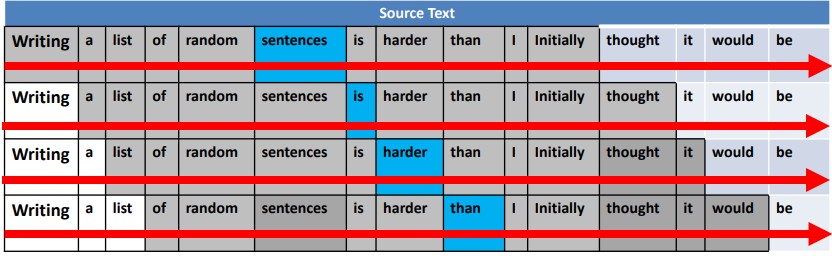

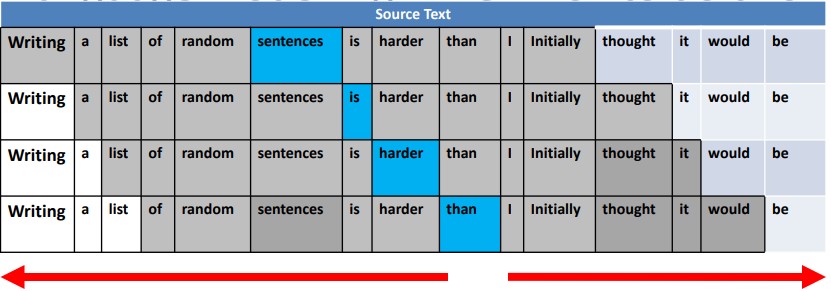

Fino a prima di BERT, i modelli di linguaggio erano unidirezionali, ossia leggevano il testo da sinistra verso destra o da destra verso sinistra. La prima rivoluzione introdotta da BERT sta nel fatto che mediante un encoder contenuto in un transformer, l’intera sequenza di parole viene letta contemporaneamente, passando così da un modello unidirezionale ad uno bidirezionale.

Modello unidirezionale

BERT

Grazie a questa caratteristica, l’algoritmo inizia ad assumere un approccio al contesto globale delle parole. Naturalmente non basta per avere un’idea chiara del significato della frase.

Basti pensare all’utilizzo dei pronomi. È molto facile anche per noi esseri umani a volte perdere traccia di chi si sta parlando in una conversazione, figuriamoci i computer. I transformer si occupano principalmente di risolvere questo tipo di problema.

BERT implementa anche due ulteriori modelli: il Masked Language Modeling e il Next Sentence Prediction.

Il modello Masked Language Modeling si occupa di sostituire il 15% delle parole di una frase con un token chiamato [MASK]. Questo avviene prima di dare tutto in pasto a BERT.

Fatto questo, tenta di indovinare il valore originale delle parole mascherate in funzione del contesto delle altre parole della frase. È un modello sicuramente più lento rispetto a quelli unidirezionali ma la lentezza è compensata da una migliore comprensione del contesto.

Il modello Next Sentence Prediction riceve coppie di frasi come input e prova a capire se la seconda frase nella coppia è quella successiva nel documento originale.

L’insieme dei risultati dei modelli aiuterà BERT a comprendere via via il contesto di un’intera frase e quindi il suo significato, stravolgendo così i risultati di ricerca presentati nelle SERP per query dal contenuto ambiguo o fino ad oggi di difficile interpretazione.

Come impatterà BERT sui risultati di ricerca

La comprensione da parte di BERT delle sfumature del linguaggio umano farà una grande differenza sul modo in cui Google interpreta le query. Oltretutto la sua efficienza si propagherà velocemente anche sui motori di ricerca nazionali in quanto molti dei pattern usati per comprendere una lingua possono essere tradotti per comprendere altre.

Questo consentirà a Google di applicare efficacemente molti degli apprendimenti di BERT in altre lingue, senza necessariamente comprendere appieno la lingua stessa.

Grazie a BERT, Google sarà in grado di comprendere meglio le sfumature contestuali e le domande ambigue. Di conseguenza è molto probabile il verificarsi di notevoli oscillazioni nei risultati di ricerca.

Come ottimizzare i contenuti per BERT

Molto probabilmente c’è poco da fare.

BERT, infatti, non mira a giudicare il contenuto di un articolo ma a meglio comprendere la query di ricerca. Di conseguenza se l’articolo non è rilevante rispetto alla query, così come compresa da BERT, è naturale che si verifichi un calo del ranking della pagina per tale query.

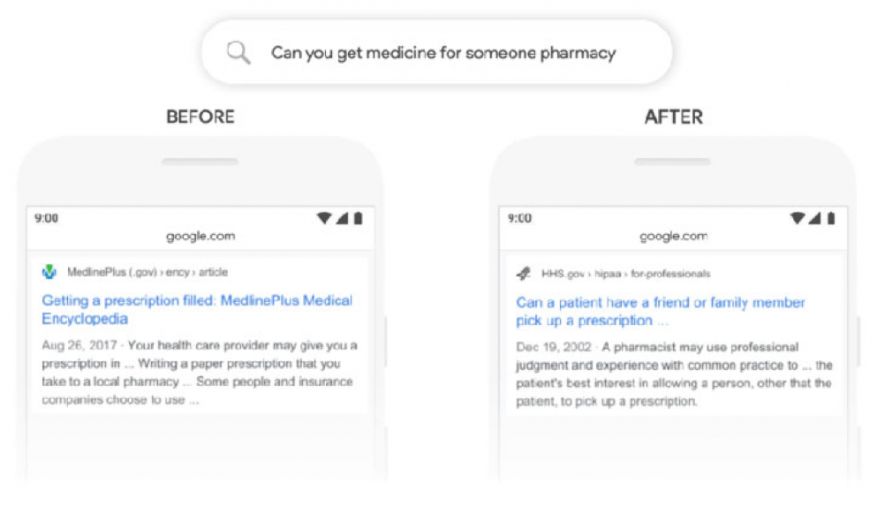

Ecco un esempio di risultato di ricerca prima e dopo BERT, riportato da Search Engine Journal. Dall’esempio è possibile notare come il secondo risultato sia di gran lunga più pertinente del primo.

Il nostro consiglio è quello di implementare i dati strutturati e di scrivere testi facilmente comprensibili, in modo naturale e senza forzature. Essendo Google adesso in grado di comprendere meglio il contenuto, potrebbe utilizzare queste nozioni per ottimizzare algoritmi come Google Panda e penalizzare pagine sovra-ottimizzate.

Ed eccoci giunti alla conclusione di questo articolo su BERT. Se ti è piaciuto e desideri rimanere aggiornato sulla pubblicazione dei nuovi, iscriviti alla nostra newsletter. Non riceverai mail email di spam, le odiamo tanto quanto te!