Home » Blog » Web Marketing » SEO: cosa determina la posizione in classifica su Google?

SEO: cosa determina la posizione in classifica su Google?

Perché un sito si trova prima di un altro nei risultati di ricerca pur trattando lo stesso argomento? Come fare a migliorare il posizionamento su Google?

Queste sono solo alcune delle domande che ogni aspirante SEO Specialist si pone almeno una volta nella vita. Ed una volta è dir poco dato che i continui aggiornamenti degli algoritmi alterano le posizioni all’interno della SERP.

In questo articolo analizzeremo i fattori che determinano il posizionamento all’interno della SERP secondo lo studio annuale condotto da searchmetrics nel 2014. Il report presenta un’analisi effettuata sui primi 30 risultati di ricerca (3 pagine di SERP) di una determinata query, per un totale di circa 10.000 parole chiavi e 300.000 URL.

Indice dei Contenuti

Definizione di correlazione statistica

Prima di proseguire bisogna aver chiaro il concetto di correlazione statistica. Per correlazione si intende la relazione tra due variabili statistiche tale che a ciascun valore della prima variabile corrisponda con una “certa regolarità” un valore della seconda.

In questo studio viene utilizzato il coefficiente di correlazione di Spearman dei migliori 30 risultati di una query di ricerca, basandoci sulle seguenti variabili statistiche:

- Posizionamento

- Presenza dei fattori fondamentali per un buon SEO

Dal report si evince che più è alto il valore della correlazione e maggiore sarà la differenza nel posizionamento all’interno della SERP.

Tecnologia interna alla pagina

Dallo studio si deduce che è fondamentale per un buon posizionamento dare la giusta importanza a tutti i fattori che determinano il SEO organico, infatti i motori di ricerca non sembrano gradire pagine che non rispettano tali criteri. Sembra inoltre che il rispetto di tali fattori sia indispensabile per ricoprire le prime posizioni nella SERP.

Velocità di caricamento del sito e della pagina

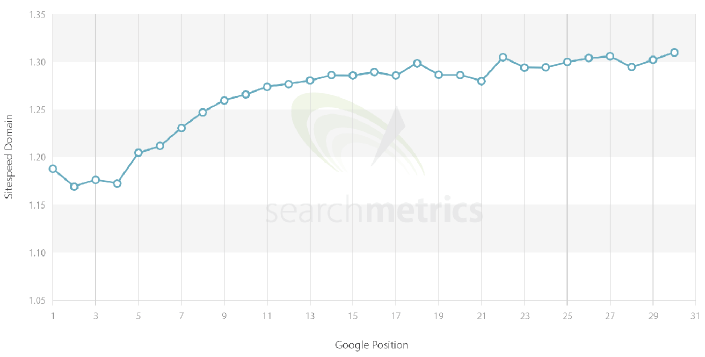

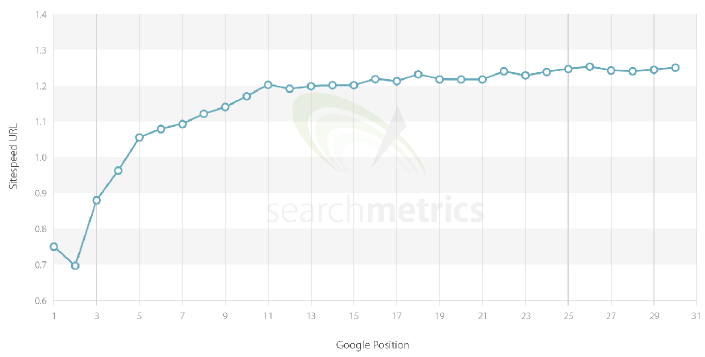

Come dimostra il grafico seguente, è chiaro come i siti in testa alla classifica dei risultati siano i più veloci. Di anno in anno è aumentata l’importanza della velocità di caricamento del sito, poiché non solo ottimizza i tempi di scansione dello spider ma aumenta anche la serenità di navigazione dell’utente, il quale la maggior parte delle volte blocca il caricamento della pagina su siti lenti.

Quindi è molto importante ottimizzare il contenuto delle pagine con tecniche di minificazione e accorpamento di file esterni come Javascript e CSS, fare uso di buoni Content Delivery Networks (CDN), comprimere le immagini ed utilizzare cache a diversi livelli.

Keyword in titolo, descrizione e intestazioni

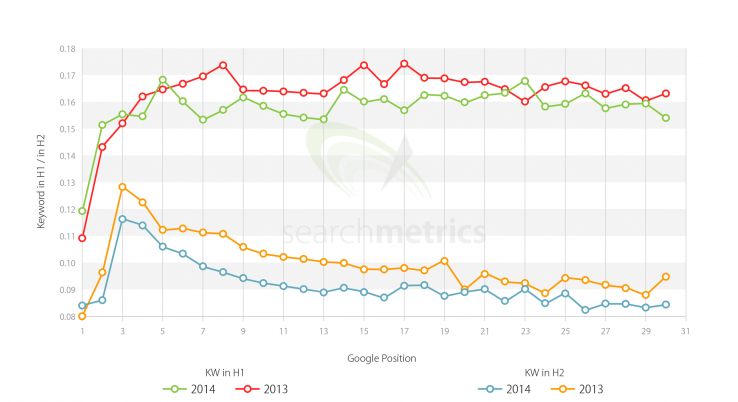

È ormai chiaro come un uso eccessivo di parole chiavi abbia un effetto negativo sul posizionamento, ma vi sono punti nella pagina dove la loro presenza è fonte di ottimizzazione.

Dallo studio si nota come dal 2012 al 2013 è diminuita l’importanza che si attribuiva alla keyword come parte integrante della URL e del dominio.

Una cosa è certa: il tempo della densità di parole chiave è ormai finito. È sempre positivo includerle nel titolo, nella descrizione e nelle intestazioni ma non bisogna sottovalutare il fattore attraenza, ovvero bisogna si sviluppare un titolo ed una descrizione quanto più vicini alla risposta di una query di ricerca, ma anche renderli attraenti all’occhio di chi li legge. Un titolo non attraente nella SERP difficilmente genera click, stessa cosa per la descrizione che deve anche innescare la giusta curiosità.

Il report riporta che tutti i top results presentano la keyword nel campo title ma che non tutti seguono la regola del meta description. Questo è dato anche dal fattore brand del quale parleremo in seguito. Ad esempio Wikipedia è ben indicizzato anche senza keyword poiché Google reputa gli articoli come rilevanti a prescindere dalla forma e dalla struttura HTML interna.

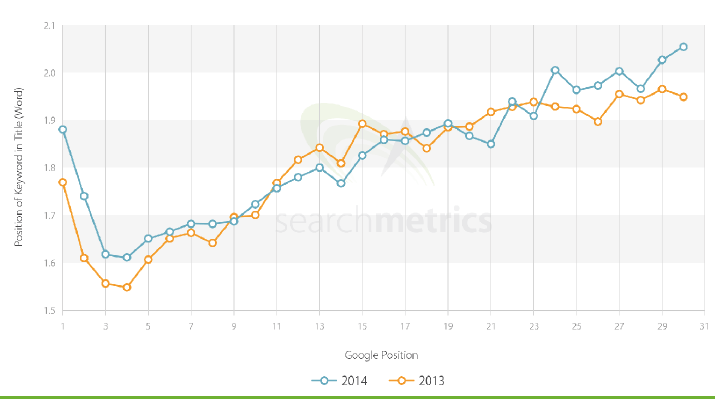

Dal seguente grafico è possibile notare come non esiste una grande differenza tra le 30 URL in classifica per quanto riguarda l’utilizzo delle keyword nelle varie intestazioni (tag H1, tag H2). Anche qui nei primi 2-3 casi il fattore brand ne fa da padrone.

Interessante invece è il risultato dell’importanza della parola chiave in base alla posizione nel titolo. Viene riconfermata la regola “più vicina, più importante”.

Riepilogo

La differenza tra i primi 30 risultati della SERP in base ai criteri tecnici è leggera, questo perché è relativamente semplice applicarli. In ogni caso un’ottima struttura tecnica è un requisito fondamentale per un buon posizionamento.

È stato visto inoltre che la presenza di parole chiavi nel dominio ha ormai poca rilevanza, a differenza invece di quelle piazzate in titoli, descrizioni e intestazioni, che però non vanno ottimizzate troppo per non indurre in spam. Aumenta sempre più l’importanza di avere un sito veloce.

Contenuto della pagina

Il contenuto della pagina e la sua qualità stanno diventando i fattori più importanti per un buon posizionamento. Può sembrare scontato ma una volta erano ben altri i fattori che incidevano sul ranking, tra i quali la densità di parole chiavi e il numero di link in ingresso.

Gli ultimi aggiornamenti degli algoritmi di Google, e quelli che verranno, mirano non solo a misurare la rilevanza del contenuto in modo da associarlo sempre più correttamente ad un determinato set di query di ricerca (applicando anche i sinonimi delle parole chiavi) ma anche a constare la leggibilità intesa come struttura testuale (forma del testo ed impaginazione) ed HTML. Google infatti intende offrire il risultato migliore in termini di contenuto informativo e leggibilità.

I fattori che determinano il contenuto possono essere classificati in 3 categorie:

- Qualità e leggibilità di un testo

- Link interni

- Materiale pubblicitario

Qualità e leggibilità di un testo

Google sta facendo passi da gigante per quanto riguarda la semantica di un testo, infatti i nuovi algoritmi prendono in considerazione il significato dell’intero testo e non più quello della singola keyword come avveniva un tempo.

Da tutti i calcoli risulta che più il testo è ricco di argomenti e più e rilevante per gli utenti che utilizzano diverse query di ricerca. Quindi è sempre buona norma utilizzare nello stesso testo anche sinonimi della parola chiave principale, tenendo ben a mente che le stop words saranno sempre filtrate poiché non rilevanti ai fini della comprensione dell’argomento.

Se un autore vuole che il suo articolo venga posizionato nel modo migliore, occorre sviluppare un contenuto tenendo a mente il modo in cui esso verrà ricercato dagli utenti.

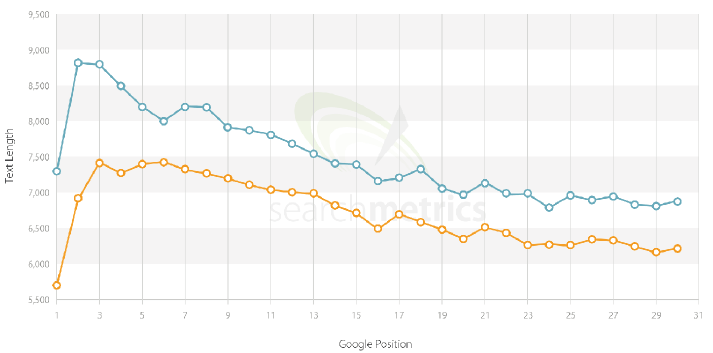

Anche la lunghezza del contenuto incide sul posizionamento. Un testo scorrevole e dettagliato, ricco di informazioni, è preferibile a testi brevi. È doveroso sottolineare però che più testo non significa che il contenuto sia qualitativamente migliore.

Un altro valore da tenere in considerazione è la leggibilità di un testo. Per quanto riguarda la lingua inglese, viene utilizzato l’indice Flesch, mentre per calcolare la leggibilità di un testo italiano occorre utilizzare l’indice Gulpease.

Il calcolo restituisce un numero che indica se un testo è difficilmente leggibile, leggibile o facilmente leggibile. Rimane comunque incerta l’incisività di tale valore nei risultati della SERP, in quanto la leggibilità può essere soggettiva.

Sono molto apprezzate le immagini all’interno del testo, che aiutano non solo l’utente ma anche Google ad indicizzare meglio il contenuto.

Link interni

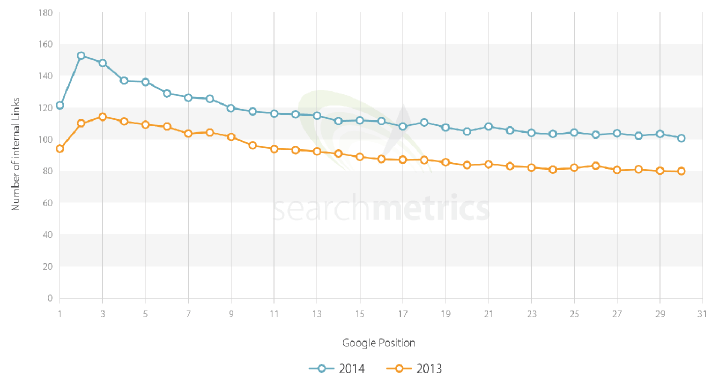

I link interni sono di vitale importanza, sia per Google che riesce a correlare gli articoli sia per l’utente che trascorre più tempo all’interno del sito e ne apprezza il contenuto.

Un link dovrebbe avere senso sia per le pagine che per le aspettative dell’utente. Link irrilevanti, non necessari o non funzionanti dovrebbero essere rimossi.

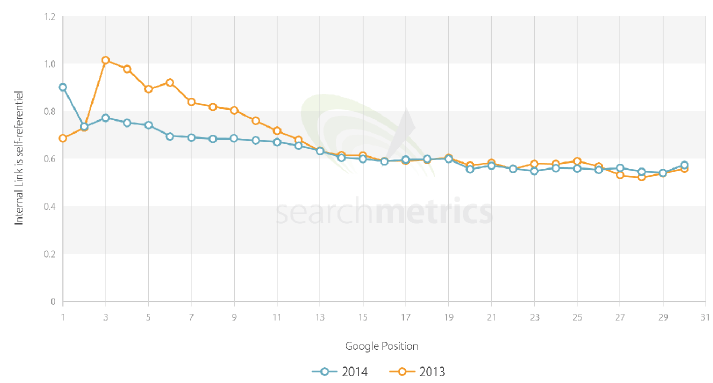

Dall’analisi sorge una domanda interessante: è una buona idea linkare una keyword da una pagina ben posizionata ad un’altra interna al sito stesso? Se si, questo implica che la pagina che riceve il link sia altrettano importante per la parola chiave specificata? Se così fosse, potrebbe una pagina ben posizionata perdere in futuro la sua posizione in classifica?

Dallo studio si evince che per aumentare il valore di una keyword di una determinata pagina, quest’ultima non deve contenere link interni. In questo modo si da’ molta più importanza all’articolo in se.

Materiale pubblicitario

Un altro dato interessante da analizzare è la presenza di link di advertising come quelli del gruppo Adsense. Infatti si è notato come i siti posizionati meglio siano quelli che ne contengono meno.

Una volta si pensava che contenere link Adsense migliorasse il ranking ma quando si è visto che così non era, in molti hanno iniziato ad eliminarli.

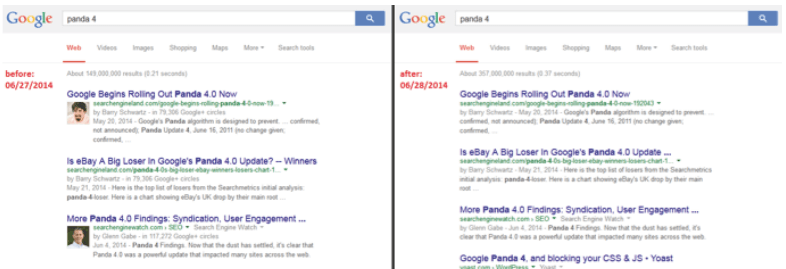

Un’ultima, ma non per importanza, analisi è quella che misura la correlazione tra posizionamento ed autorship. Inizialmente Google permetteva di associare un profilo Google+ ad un articolo, visualizzando nome e foto dell’autore nella SERP. Questo ha avuto un grande impatto nel CTR, ma Google ha di recente rimosso la visualizzazione della foto, ad eccezione per Google News.

Dagli studi comunque si nota come non esiste correlazione tra posizionamento e autorship.

Link in ingresso

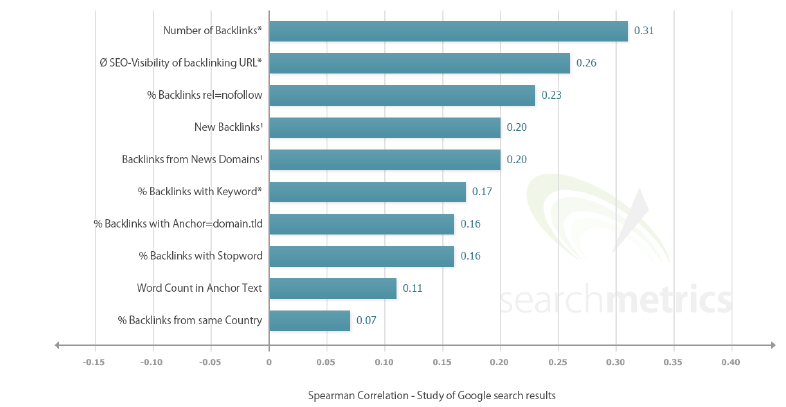

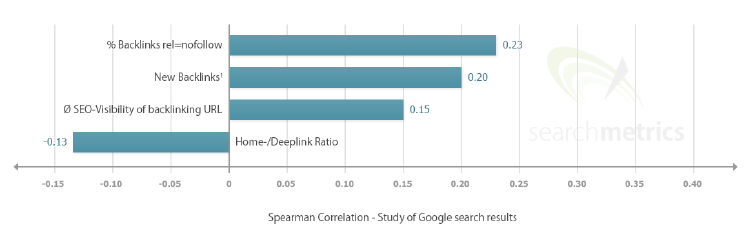

I backlink sono il fattore SEO più importante per il posizionamento e determinano il valore dell’ormai famoso PageRank. A differenza dei tempi passati, oggi non importa solo il numero dei link in ingresso ma anche la loro qualità, infatti gli ultimi aggiornamenti sono riusciti a contrastare per bene le tecniche di black hat link building che miravano a realizzare un alto numero di inbound link ma di scarsa qualità.

Senza scendere troppo nei dettagli, oggi ad un link viene assegnato un valore qualitativo che incide sul posizionamento del sito di destinazione. Link provenienti da siti contrassegnati come spam incidono negativamente e portano a penalizzazioni. Link provenienti da pagine che hanno un alto numero di link in uscita incidono sul posizionamento in modo molto sottile o nullo.

Più una pagina contiene link in uscita, più il valore qualitativo di questi si abbassa. Ovviamente la qualità non dipende solo da questo ma anche dal tema trattato (sarebbe strano infatti che una pagina che parla di cucina linkasse un sito che parla di Android), dall’importanza della pagina stessa per Google (il valore del PageRank e la popolarità sui Social Network), dal posizionamento del link all’interno del contesto (il link si trova in alto all’articolo o in fondo?), l’anchor text e tante altre caratteristiche.

Quindi il numero di backlink rimane un fattore molto importante ma che adesso deve tenere conto anche della qualità della fonte come dimostrato chiaramente dal seguente grafico.

I brand maggiori hanno nuovi backlink in continuazione. Quindi uno dei fattori molto importanti da tenere in considerazione quando ci si trova ad effettuare link building è proprio la fornitura continua ma graduale di nuovi link, ed a seconda di dove questi sono posizionati, occorre inserire il l’attributo rel=”nofollow” al fine di non incorrere in penalizzazioni.

Molto importante è anche l’età del link: le pagine con un rank più alto sono linkate da siti più anziani. Questo fattore si ricollega al numero di backlink, ovvero i siti con il numero di più alto di backlink sono quelli che contengono anche link più vecchi.

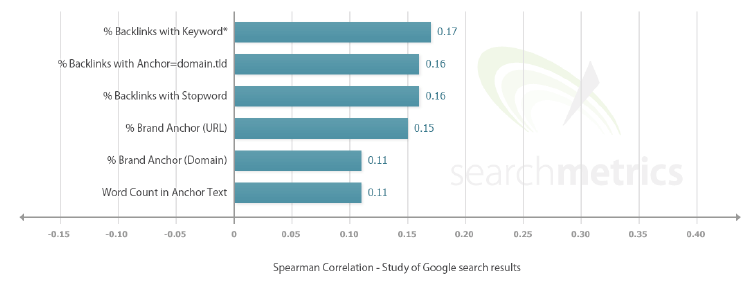

Le keyword negli anchor text sono sempre più rare. I webmaster hanno iniziato a cambiare il proprio modo di linkare una fonte, anche per via degli ultimi aggiornamenti di Penguin. Tra i cambiamenti che si possono notare al volo troviamo link non più composti da una singola parola chiave e link che contengono stop words per una migliore leggibilità.

Nonostante i backlink con keyword in anchor text siano ben posizionati, solo il 25% di questi sono presenti per i primi 30 siti della SERP in analisi.

Riepilogo

Un ottimo profilo di link ingresso è importante per il SEO. Bisogna prendere in considerazione non solo il numero di backlink ma anche la qualità della fonte. Bilanciare entrambi i fattori sembra essere il segreto di un buon posizionamento.

I fattori keyword hanno subito una svalutazione da parte degli ultimi aggiornamenti di Penguin ed i link sono divenuti più naturali. Questo non vale per i link verso grossi brand che hanno più link “domain.tld”, link sempre nuovi, molti deep link e sono in continuazione linkati da siti che trattano news.

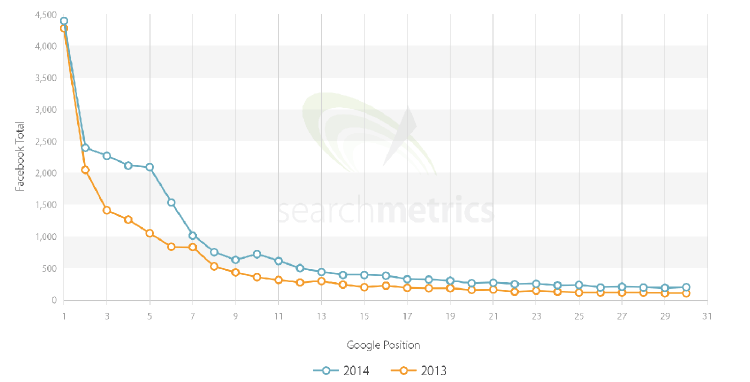

Popolarità su Social Network

Che i social network potessero influire sul posizionamento è cosa ormai risaputa. Perché? Perché il profilo è il più delle volte legato ad una persona vera e quindi il gesto di condivisione come espressione di preferenza è un fattore che non può non essere preso in considerazione in quanto riguarda l’esperienza diretta dell’utente.

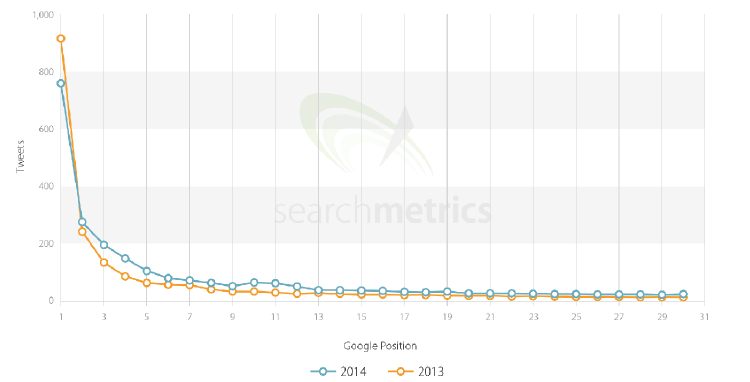

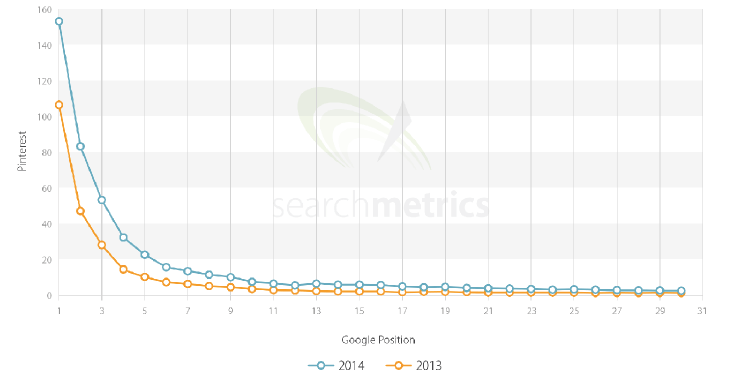

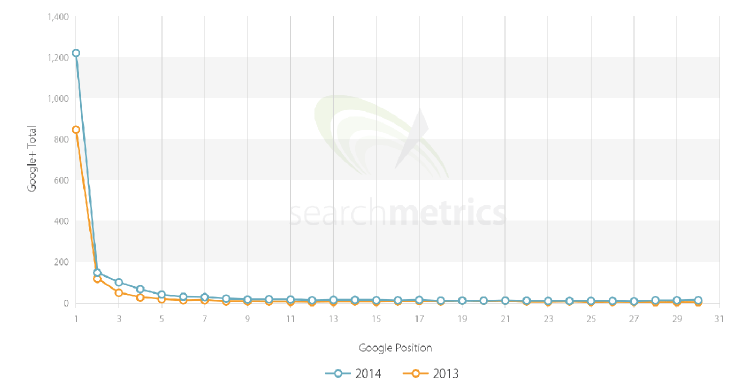

Anche se negli ultimi tempi l’importanza dei social signals è diminuita, rimane comunque alta. Chiaramente vengono prese in considerazione tutte le metriche, ovvero condivisoni, commenti e “mi piace”. Di seguito riportiamo i grafici che correlano la posizione su Google con i comportamenti degli utenti sui maggiori social network, ovvero Facebook, Twitter, Pinterest e Google Plus.

Fattore brand

Il fattore brand è un fenomeno che influenza la SERP con metriche diverse da quelle classiche, infatti è possibile trovare nelle prime posizioni siti che non rispettano al 100% le regole basi per avere un buon SEO. Ad esempio molti di loro sempre più raramente inseriscono keyword nei titoli e nelle descrizioni, ancora più nelle intestazioni.

I grossi brand sono ritenuti affidabili da Google a priori. Un esempio palese e Wikipedia ma ve ne sono molti altri come Youtube, IMDB ecc..

Tutti i brand hanno un punto in comune: un numero enorme di backlink provenienti sia da fonti autorevoli che da fonti meno autorevoli ma comunque qualitativamente discrete, che porta loro ad avere un alto valore di PageRank. Un sito di spam difficilmente linka un brand e comunque non influirebbe negativamente. Un altro punto in comune è l’alta mole di traffico misurabile dal grado Alexa.

Come conclusione è possibile affermare che Google tratta i brand in un modo differente e che riserva loro le posizioni migliori della SERP. Per tutti i siti non-brand riuscire a ricoprire le prime posizioni allo stesso modo dei sopra citati è difficilissimo se non totalmente impossibile.

Comportamento del visitatore

Tutti i calcoli presentati fino ad ora sono tutti basati su dati disponibili liberamente. Tuttavia solo Google conosce il funzionamento esatto dei propri algoritmi e quindi il vero fattore ranking che determina il posizionamento.

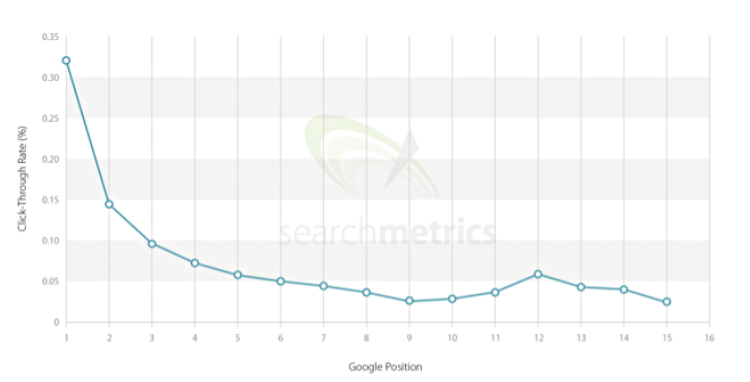

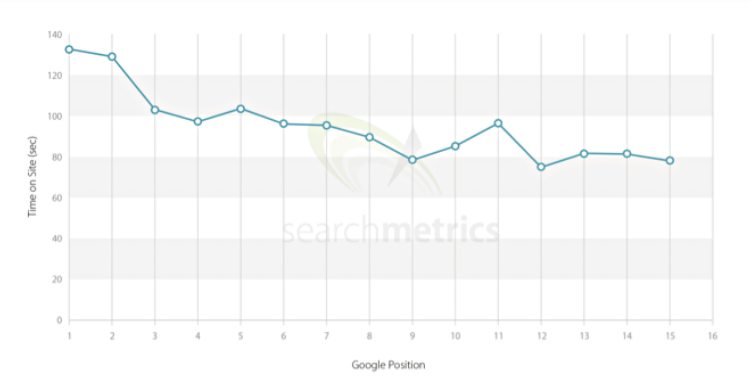

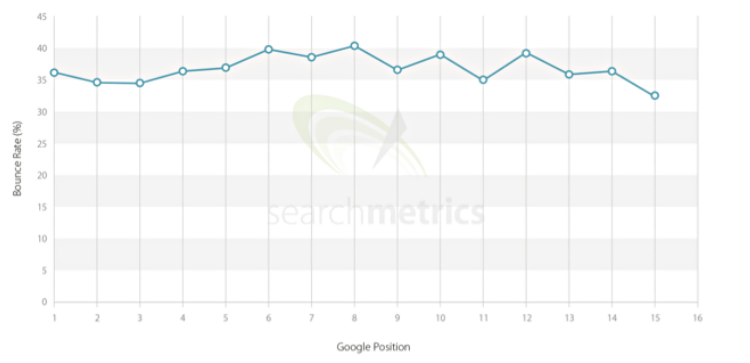

È doveroso dare uno sguardo alla correlazione tra il tasso di click effettuati nella SERP, il tempo di permanenza dell’utente sul sito ed il bounce rate.

Possiamo vedere dal grafico sottostante come i siti che stanno nelle posizioni migliori sono pure quelli con un CTR maggiore. Ciò non vuol dire che da oggi dovete iniziare a cliccarvi da solo il sito, anche perché questo porterebbe Google a penalizzarvi sulla query che avete utilizzato per ricercarvi.

Stessa cosa vale per il tempo di permanenza sul sito ed il bounce rate. Sono tutti valori che quasi sicuramente Google prenderà in considerazione in quanto riflettono l’esperienza dell’utente.

Supporto mobile

Google ha dato e continua a dare moltissima importanza a tutti i siti che offrono un pieno supporto per dispositivi mobile come tablet e smartphone, questi ultimi in particolare. Lo ha dimostrato con l’introduzione dell’ultimo algoritmo chiamato Mobilegeddon ma anche con i nuovi servizi che saranno pubblicati nei giorni a venire come la possibilità di acquistare direttamente dalla SERP, dedicata a dispositivi mobile.

I risultati della SERP oggi sono compromessi se la ricerca viene effettuata da dispositivi mobile. Chiaramente per questi ultimi viene fornito non solo il risultato più attinente ma anche quello più navigabile.

Riepilogo

I motori di ricerca applicano degli algoritmi automatici al fine di valutare un sito web in base al contesto ed alla rilevanza.

Gli algoritmi sono chiaramente indispensabili in un Internet dove i documenti pubblicati ogni giorno sono talmente tanti che è impensabile applicare uno per uno una supervisione umana. Ovviamente, per motivi concorrenziali, le informazioni che ne disciplinano il funzionamento sono segrete. Nessuno a parte Google conosce al 100% il comportamento dei propri algoritmi e quindi i fattori che determinano il ranking. Tuttavia è possibile dedurre delle informazioni analizzando la mole di dati disponibili, un po’ come si fa quando si analizza un sistema blackbox.